Julie Blanc – Composer avec les technologies du web

Faire état de l’art

Faire état de l’art

Nous nous proposons de diviser cet état de l’art en trois parties. Dans un premier temps, nous retraçons l’évolution historico-culturelle de l’activité de composition en nous basant sur l’idée que les contradictions actuelles d’un système d’activité ne peuvent s’éclairer qu’à la lumière de son histoire passée. Dans un deuxième temps, nous évoquons les relations entretenues entre l’activité de composition et l’histoire du web. Nous y rappelons que le web a principalement été créé pour la publication de documents et nous y discutons les caractéristiques uniques du langage CSS vis-à-vis des pratiques de design graphique. Enfin, dans un troisième temps, nous nous emploierons à contextualiser la culture du logiciel libre et particulièrement les valeurs qui l’encadrent.

Formation historico-culturelle de l’activité de composition

Le

plomb manuel : l’imprimerie

et

la composition comme activité ouvrière

La conception et la production d’ouvrages imprimés en série sont rattachées à une longue histoire débutant par l’invention de la presse typographique par Johannes Gutenberg à la moitié du XVe siècle. Dans les ateliers d’imprimerie, l’organisation de la production change peu pendant près de quatre siècles. Les pages sont composées à partir de caractères en plomb individuels assemblés manuellement en ligne de texte puis en page. L’impression des textes se fait à partir de la pression des caractères encrés sur le papier. Quant aux images, elles sont produites à partir de divers procédés de gravure et sont imprimées dans un second temps. Ces quelques siècles sont marqués par l’apparition progressive des formes graphiques propres au livre imprimé tel qu’on le connaît aujourd’hui (division du texte en chapitre, numérotation des pages, emploi du titre courant, etc.).

Les fonctions d’édition et d’imprimerie, alors indistinctes, se séparent progressivement au cours du XVIIIe siècle. Les imprimeurs se spécialisent alors dans la composition et la fabrication des imprimés, laissant à l’éditeur la responsabilité de la commercialisation. À la suite de la révolution industrielle, l’imprimerie connaît de grands changements (presses à vapeur créé par Friedrich Kœnig en 1814, presse rotative inventée en 1833 par Richard Hœ) qui donnent lieu à une plus grande vitesse d’impression et à la production de masse. Toutefois, le procédé reste relativement le même. Les évolutions de la production imprimées sont surtout marquées par des avancées techniques liées à la fabrication des encres et du papier, le perfectionnement de la gravure des poinçons pour concevoir les caractère de plomb et la multiplication des procédés de gravure liéeà la reproduction des images (gravure sur bois, linogravure, gravure en taille douce, lithographie, héliogravure, etc.). Les imprimeries se multiplient dans les grandes villes et se spécialisent peu à peu en secteurs d’activité précis pour faire face à la diversité croissante des travaux : travaux de ville, bibelots1, labeur (les livres), affiches, etc.

Au XIXe siècle, les ateliers d’impression sont extrêmement hiérarchisés et sont composés d’une multitude de corps de métiers spécialisés : chef d’atelier, graveur, tireur d’épreuve, pressier, metteur en page, margeur, etc. Au cœur de ce système : les ouvriers typographes ou « compositeurs », qui composent les livres en assemblant un à un les caractères en plomb. Ce sont eux qui forment la masse de la main-d’œuvre dans les ateliers d’imprimerie. Chacun d’entre eux reçoit un papier manuscrit (la « copie ») présentant le texte à composer et la longueur de la ligne désirée et doit s’occuper d’aligner les caractères en plomb un à un afin de former le texte.

Pour que l’ouvrier2, qui prend tout naturellement le nom de compositeur, puisse faire ce travail avec méthode et surtout sans perte de temps, les caractères sont disposés par sortes dans un grand casier à compartiments qu’on appelle casse. (…) La partie supérieure de la casse, comprenant 98 cassetins, dans lesquels sont distribués les capitales grandes et petites, les lettres supérieures et la plupart des signes de ponctuation, s’appelle haut de casse. La partie inférieure de 54 cassetins, contenant les lettres ordinaires, les chiffres et les espaces, s’appelle bas de casse, ce qui fait qu’on donne le nom de bas de casse aux caractères courants. (…)

L’ouvrier assis sur un haut tabouret, mais plus généralement debout devant la casse, sur laquelle est fixée sa copie, a dans la main gauche son composteur, espèce de règle à rebords, munie d’une coulisse qu’il a fixée d’avance à la longueur exacte des lignes à composer (ce qu’on appelle justifier son composteur), dont le plan doit recevoir les lettres au fur et à mesure qu’il les lève des cassetins, avec une rapidité qui étonne les non-initiés.3

Le salaire des ouvriers typographes est directement proportionné au travail accompli et donc à la rapidité d’exécution. Notons à cette occasion que l’imprimerie est marquée par une organisation très corporatiste des métiers avec des syndicats particulièrement forts. Les ouvriers-typographes constituent une élite ouvrière qualifiée, notamment parce qu’ils sont lettrés. En ce sens, ils sont considérés comme les « aristocrates de la classe ouvrière4 ».

Quand 5 ou 6 lignes sont assemblées, elles sont enlevées du composteur et déposées dans la galée (un plateau métallique ou en bois), assez grande pour contenir le bloc de texte d’une page. Lorsque la galée est prête, elle est ensuite apportée sur le marbre (la « table de montage »), où les morceaux de texte composés sont assemblés avec les autres éléments de la page (foliotage, filets verticaux ou horizontaux, gravures éventuelles, vignettes, notes, etc.) pour obtenir la forme qui sera imprimée. Celle-ci est alors directement envoyée aux presses d’impressions pour effectuer la reproduction.

Une fois que le texte est imprimé, une nouvelle étape – la distribution – revient au compositeur. La distribution désigne l’opération inverse de la composition. Il s’agit de remettre à leur place, dans leurs casses, les caractères, afin qu’ils puissent servir à une nouvelle composition. L’organisation de l’imprimerie repose ainsi sur une succession de tâche très matérielles et prend place dans de véritables usines : il faut de la place pour loger à la fois les ouvriers-typographes et leurs casses ainsi que l’ensemble des machines nécessaire à l’impression et la fabrication des livres. Ainsi, mise en page, composition, imprimerie, fabrication sont des activités matériellement liées et prenant place toutes dans le même lieu.

Le

plomb mécanique :

la naissance

de l’industrie graphique

La fin du XIXe siècle et le début du XXe siècle sont marqués par de forts progrès techniques et une industrialisation massive de l’imprimerie : mécanisation de la composition typographique et de l’impression, généralisation des procédés photomécaniques, développement des marchés de masse. L’évolution des moyens de reproduction photographique (photogravure, héliogravure, offset) entraîne l’apparition d’un ensemble de corps de métiers spécialisés : photograveurs, héliograveurs, galvanotypes, conducteurs de machines offset, etc. Toutefois, la production d’images reste encore séparée de la production du texte.

Les inventeurs se penchent alors sur la mécanisation de la composition textuelle – dernier secteur de l’imprimerie a être encore complètement manuel. Entre 1820 et 1950, près de 300 brevets sont déposés autour de machines permettant de mécaniser le travail de composition et celui de distribution des caractères5. Ce sont finalement les composeuses-fondeuses qui s’imposeront sur le marché à la fin du XIXe siècle, dont les modèles les plus connus sont la Linotype et la Monotype6.

Ces machines répondent à plusieurs problématiques du travail des ouvriers typographes : la suppression du travail de distribution, la simplification de la justification, la facilitation de la manipulation de plusieurs fontes et surtout le remplacement de la manipulation manuelle des caractères par une saisie au clavier et donc l’augmentation de la vitesse de composition et l’allègement du travail physique.

La Linotype

est une machine de près d’une tonne qui est composée d’un

clavier de 90 caractères où chaque frappe est liée à une matrice en cuivre ou laiton

dans un magasin. Chaque matrice correspond à l’empreinte d’un caractère.

Entre chaque mot, la Linotype

insére des « blancs » ajustables lorsque l’opérateur presse la

touche espace tout à la gauche du clavier. Ces blancs permettent de résoudre

mécaniquement l’opération de justification (le fait d’aligner le

texte à gauche et à droite afin d’obtenir un bloc).

Lorsque la ligne est composée, le typographe presse un levier

à la droite du clavier qui

transfère cette ligne dans la chambre de coulée puis il lève le

levier de justification, ce qui pousse simultanément les écarteurs

d’espace à la même hauteur

afin que les matrices occupent toute la largeur de la ligne.

La machine coule un

alliage

étain-plomb-antimoine

à bas point de fusion sur la

ligne-bloc, qui sert de moule. La machine crée ainsi une ligne

typographique d’un seul tenant qui n’a plus qu’à être encrée pour

faire l’impression. Une fois

que les lignes sont coulées, les matrices sont amenées dans une

machine qui se charge de les ranger (les distribuer) grâce aux

différents crans des moules. Triées, elles sont ramenées dans les

magasins des machines à composer. Par ailleurs, les magasins de matrices

sont assez grands pour contenir les matrices des caractères en

romain et en italique, ce qui facilite la manipulation d’un style

à l’autre.

Le système Monotype

repose quant à lui sur deux machines distinctes : la machine de frappe des caractères qui permet de produire des bandes perforées et la machine de fonte. Sur la machine de frappe, un grand clavier permet de perforer un ruban de papier qui est ensuite monté sur la machine de fonte afin de la piloter. La combinaison des trous dans le ruban indique l’emplacement d’un caractère sur la matrice de moulage. Dans la machine de fonte, chaque caractère est positionné selon une localisation particulière sur une matrice rectangulaire comportant tous les caractères d’une fonte (255 localisations). La matrice est déplacée par un système d’air à compression selon la lecture de la bande perforée pour positionner le bon caractère face à un moule. Le métal est alors coulé à travers la matrice.

D’une part, le système Monotype facilite la correction (puisque les caractères restent indépendants) et, d’autre part, la bande perforée permet de conserver du texte composé, sans immobiliser d’encombrantes formes en plomb et sans avoir à saisir de nouveau le texte. De plus, la division du processus en deux étapes séparées met l’opérateur claviste à l’abri des vapeurs toxiques du plomb (ce qui n’est pas le cas de la Linotype qui pose des problèmes de saturnisme et de chaleur). Notons toutefois que cette division a aussi été l’occasion d’une tentative, de la part des maîtres imprimeurs – focalisés sur une plus grande rentabilité de production – de remplacer les compositeurs-typographes par une main-d’œuvre essentiellement féminine, moins qualifiée et donc payée au rabais7. Les stratégies corporatives et syndicales des compositeurs leur permettront tout de même d’obtenir une « mécanisation négociée8 », en évitant à la fois la disqualification de leur activité et une amélioration de leurs conditions de travail9.

La composition mécanique s’impose d’abord rapidement et massivement dans la presse quotidienne via la Linotype. La vitesse moyenne de composition sur Linotype est de l’ordre de 5 000 signes par heure, soit 5 fois plus qu’en composition manuelle. Surtout, la manipulation sur le marbre est facilitée par les lignes-blocs faciles à empiler et à déplacer en cours de mise en page. La Monotype est plutôt privilégiée dans l’édition d’ouvrages de qualité, restant toutefois en concurrence avec la composition manuelle pour certains travaux mineurs et spécialisés.

L’apparition de la figure du Typographe

Le typographe en tant que concepteur (typo)graphique – distinct

de l’ouvrier typographe – apparaît comme une figure nouvelle au

début du XXesiècle. Il est le résultat de la séparation

progressive des activités de conception et d’exécution au sein des

imprimeries à mesure de

l’adoption de la mécanisation de la composition. Bien que le terme « design graphique »

apparaisse pour la première fois en 1922 sous la plume de William

Addison Dwiggins10, il lui sera préféré le terme

de « typographe » dans l’industrie du livre – dans le sens moderne

du terme anglo-saxon :

« typographers », ceux qui s’occupent de la présentation

du texte et non de son assemblage.

Dans les ateliers d’imprimerie, jusqu’à la fin du xixe siècle, la réalisation des maquettes pour les objets imprimés et les livres, ne procède pas d’une profession correctement définie. Ce sont souvent les maîtres d’atelier, l’imprimeur ou l’éditeur en commande qui se chargent de définir les choix de caractère, la taille du bloc et les éléments graphiques en appui. Des concepteurs dédiés aux travaux d’imprimerie et qui s’occupent exclusivement des maquettes (de livres uniques ou de collections) apparaissent peu à peu. Ni tout à fait un ouvrier, ni tout à fait un artiste, le typographe est en charge de la création graphique. Il donne les directives de la mise en page (format marge, disposition du bloc de texte, etc.), choisit l’iconographie ou encore spécifie les caractéristiques de chaque élément typographique (taille du corps, interlignage, justification).

Les maquettes sont dessinées à la main à partir de pages types avec l’aide de règles, d’équerre, de compas et tout un ensemble d’instruments graphiques. Elles sont accompagnées de « notes de composition », des documents techniques détaillant la mise en page et les règles de composition à respecter pour l’ouvrage. Toutes les spécifications typographiques y sont indiquées : styles de caractères, corps, justifications, interlignages, dimensions des marges, etc.11 Le travail du typographe est alors indissociable du travail en atelier d’imprimerie et exige une très bonne connaissance des problèmes techniques de l’édition.

Avec la consécration de la figure du typographe, les premières théorisations de la mise en page apparaissent en Europe, servant de guide à la création. Le mouvement de la Nouvelle Typographie en Suisse et en Allemagne, rattaché à la modernité et à la recherche d’une forme typographique qui soit conforme à son époque, en est l’exemple le plus éclatant12. Le souci de la « chose imprimée13 » gagne aussi la France, mais de manière plus confidentielle. La revue Arts et Métiers graphiques, fondée par Charles Peignot dans les années 1920, a pour fonction de remédier à « l’absence quasi totale de culture et de curiosité typographiques dans le monde de l’imprimerie et dans celui de l’édition ». La fin des années 40 marque un vrai tournant pour l’édition française et contribue à sortir les typographes des ateliers d’imprimerie. À la sortie de la guerre, le mouvement des Clubs du livre donne un visage nouveau de la mise en page du livre ; notamment pour son rapport au cinéma et à l’architecture. Pierre Faucheux, véritable « architecte du livre » transforme le concept de maquette du livre. Il substitue « au travail automatique de l’imprimeur sur directives, un travail détaillé et minutieux page à page, ligne par ligne souvent14 ». Les indications de composition sont extrêmement précises15 et vont parfois jusqu’à la préfabrication entière des ouvrages avec des maquettes reliées. Stimulé par le nouveau développement des maisons d’éditions et l’apparition des grandes collections qui nécessitent une refonte graphique importante, Pierre Faucheux fonde en 1947 un véritable atelier consacré à la typographie éditoriale, le premier du genre en France16.

La

photocomposition :

morcellement

de la chaîne graphique

Le plomb est une matière lourde, coûteuse, difficile à manier et à stocker. Dès le début du XXe siècle, des inventeurs cherchent donc un moyen de composer des textes photographiquement afin de tirer pleinement profit des nouveaux procédés photomécaniques d’impression déjà utilisés pour les images photographiques mais non adaptés à la composition des textes17. En 1948, deux ingénieurs français, René Higonnet et Louis Moyroud, mettent alors au point une machine à composer photographique, la Lumitype-Photon18. Le principe de la machine est, a priori, simple : « un faisceau de lumière passe à travers un disque où se trouve une lettre gravée. L’image est alors projetée sur un film photographique où elle sera donc en positif. Un système de zoom permet d’avoir diverses forces de corps et de placer les lettres les unes après les autres dans un livre19. » À la sortie de la machine, on obtient de longues bandes de textes composées en colonne, sans coupure, sur support papier ou sur film photographique. Ces bandes de textes sont ensuite découpées pour former la mise en page à laquelle s’ajoute différents éléments comme les titres photographiés sur des machines spéci-ales ou les illustrations et les images préparées par des équipes de photogravure. La maquette est ensuite photographiée et le négatif est exposé sur une plaque offset qui permettra la reproduction et l’impression des pages.

Ce nouveau procédé offre l’avantage majeur d’une meilleure intégration du texte et de l’image puisqu’ils sont tous deux produits avec la même technique de reproduction (la photographie) et d’impression (l’offset). Il permet aussi d’avoir accès à une plus grande variété de caractères dans un espace de stockage considérablement réduit comparé aux besoins de la compositino au plomb20.

L’introduction progressive de la photocomposition dans les ateliers d’imprimerie français au début des années 6021 marque une rupture définitive avec les techniques héritées de Gutenberg – passant de la composition « chaude » à la composition « froide » – et bouleverse complètement l’organisation de l’imprimerie, dissociant saisie du texte, composition, conception graphique et montage22. Alors que les techniques de composition et de reproductibilité des objets imprimés étaient jusque là liées, elles suivront alors des évolutions distinctes, avec notamment d’un côté, le travail de conception graphique et d’assemblage et de, l’autre, le travail de composition.

Le travail de conception graphique et d’assemblage

Le travail de mise en page commence dans l’atelier de graphisme, où le.la graphiste schématise des idées et imagine l’organisation des ouvrages à partir d’une copie manuscrite envoyée par l’éditeur. Une fois les choix de mise en page effectués, la copie est annotée avec, pour chaque élément, les indications du choix des caractères, leur taille, l’interlignage, l’interlettrage et la justification. Les graphistes qui conçoivent la maquette doivent avoir une grande habileté de projection. Pour les aider à imaginer le résultats, ils·elles disposent d’un ensemble d’ouvrages et d’instruments : catalogues de fonderies avec les caractères disponibles, guides de références divers, instruments de calculs, etc. Malgré ces aides, la projection du résultat final lors de la conception reste difficile. Compositeur et designer graphique, Taylor Conrad déplore ainsi le manque de visualisation amené par les processus de photocomposition :

Je souhaitais voir plus rapidement le résultat de mes décisions quant au graphisme. De ce point de vue là, l’utilisation de machines à composer représentait un recul par rapport au plomb. Au moins, lorsque nous assemblions manuellement des types, nous pouvions nous rendre compte immédiatement de la mise en page ; on pouvait rapidement corriger la morasse et retoucher la mise en page sur le marbre en insérant ou en enlevant interlignes et autres espaces.23

La copie annotée est alors envoyée aux entreprises de composition, qui renvoient le lendemain ou quelques jours plus tard de longues bandes de papier ou de films photographiques – appelées les bromures – avec les colonnes de textes composées selon les spécifications envoyées. Une fois les bandes de textes reçues des ateliers de composition, les graphistes-maquettistes peuvent s’atteler au montage de la maquette composée de plusieurs pages types ou de pages spéciales. Sur leur table de montage, ils·elles assemblent tous les éléments de la mise en page préparés en amont (titrages photocopiés depuis les livres spécimens, lettres transfert, emplacement des photographies et images24, etc.) à l’aide de cutteur, colle, règles, feutres et autres outils manuels dédiés à la découpe, au collage ou au tracé25. Les différents éléments graphiques sont découpés à partir de photocopies ou dessinés à la main à l’aide de feutres techniques, ruban adhésif en vinyle, compas, règles et autres instruments. Chaque ouvrage est un produit artisanal, le travail est minutieux et physique (blessure au scalpel, cire collante qui s’étale partout, etc.).

La maquettes et ses différents éléments (les pages types, les bandes de textes photocomposés et les images originales) sont ensuite envoyés aux imprimeries où les préparateurs et monteurs se chargent d’assembler tous les éléments pour faire des pages complètes sur film transparent. Ils s’occupent ensuite d’imposer les pages – c’est-à-dire grouper les pages afin qu’après pliage de la feuille imprimée, elles soient dans l’ordre voulu – et enfin de les « flasher », c’est-à-dire transférer les films sur les plaques offsets destinés à l’impression par un processus d’insolation.

Le travail de composition

Au sein des ateliers de composition, le traditionnel compositeur est remplacé par le photocompositeur, opérateur en charge de ces imposantes machines munies d’un clavier sur lequel il peut saisir le texte et les instructions de composition. Dès la deuxième génération (au milieu des années 70), les photocomposeuses sont équipée de calculateurs électroniques (micro-ordinateurs) permettant de répartir automatiquement les caractères et les mots sur la ligne de justification et d’assurer la coupures de mots. Le développement de machines de traitement de texte séparé introduit des systèmes de balisage des textes produisant des supports magnétiques pouvant ensuite être introduits dans les machines, séparant alors les étapes de saisie et de composition26. À la fin des années 1970, les langages de balisages standardisés se développent pour décrire la structure des documents à composer et mettre en page ces mêmes documents avec les photocomposeuses et les machines de traitements de texte informatiques27.

La saisie et le balisage des textes sur des machines spécifiques ouvrent la voie au recrutement d’opératrices spécialisées – les dactylographes – bien souvent des femmes moins bien payées, moins organisées en syndicats et plus facilement remplaçables que les compositeurs. La saisie s’effectue alors de plus en plus en dehors des milieux traditionnels de l’imprimerie et de la composition, préfigurant ce qui deviendra un travail de bureautique de plus en plus pris en charge par les secrétaires de rédaction.

La photocomposition est une véritable industrie à son époque, avec des avancées techniques rapides en quelques années et une multiplication impressionnante des machines. Au sein des entreprises, les opérateur·rice·s sont spécialisé·e·s dans certains types de machines. La fragmentation du marché entre des dizaines de fabricants de photocomposeuses implique que chacun posséde ses propres interfaces d’instructions et ses propres formats de disquettes pour les caractères en négatif. C’est la même chose pour les machines de traitement de texte : chacune possédait son propre langage de balisage, ses propres instructions de formatage et même son propre format de disquette.

La chaîne graphique, une organisation complexe

Cette nouvelle organisation est nommée la « chaîne graphique ». De grandes entreprises spécialisées dans la photocomposition sont montées. Des studios dédiés au graphisme voient le jour, favorisant l’émergence du designer graphique tel que l’on l’entend aujourd’hui. Les ateliers d’imprimerie tels qu’ils étaient à l’époque de la composition au plomb disparaissent peu à peu ou se transforment pour se concentrer soit sur le processus de photogravure soit sur celui d’impression en tant que tel. Chacun des lieux où s’exercent ces activités est marqué par sa propre organisation technique et l’ensemble de la chaîne graphique est caractérisée par de très nombreux échanges entre les différents acteur·rice·s, rendant son organisation laborieuse et même, selon Taylor Conrad, « inefficace » car redondante28. Les documents sont saisis et marqués plusieurs fois : par les maisons d’éditions pour le tapuscrit, puis spécifié à la main par le·la graphiste, saisi à nouveau et balisé dans les entreprises de photocompositions (ou externalisés dans des officines spécialisés en dactylographies). La chaîne graphique est extrêmement morcelée, peu linéaire et marquée par de nombreux allers-retours exigés par des cycles de contrôles et les relations techniques et économiques complexes entre éditeurs, imprimeurs, photocompositeurs, correcteur·rice·s et graphistes.

Les formes d’organisation du travail de la production graphique et typographique sont très hétérogènes en fonction de la nature des travaux, la complexité des documents et des techniques employées29. La séparation des activités et des tâches est plus ou moins rigoureuse. En réalité, tout n’est pas hermétique et certains agents sont appelés à intervenir à plusieurs reprises dans le processus de conception et de production.

Une professionnalisation du graphisme

Cependant, pour les graphistes, l’introduction de la photocomposition signe un bouleversement et une remarquable promotion socio-professionnelle. En sortant définitivement des ateliers d’imprimerie, ils·elles parachèvent la mutation organisationnelle du travail typographique entamée quelques années auparavant et s’imposent comme des agents clés dans le nouvelle chaîne graphique, autant dans sa conception que dans sa réalisation. La légitimation du travail graphique se construit aussi à travers de nouveaux champs d’intervention : communication visuelle, images de marques, scénographie d’exposition, etc.30 Cette reconnaissance se traduit au niveau du lexique puisque le terme « graphiste » se répand dans les publications, et notamment les publications consacrées à la formation professionnelle. Les « graphistes » deviennent une catégorie socio-professionnelle à part entière, rattachée aux professions artistiques mais qui s’en distingue par « [leur] capacité à incarner la création artistique comme métier ; pratique professionnelle pleinement insérée dans l’activité économique du pays, soit une activité ici aussi éloignée de la bohème qu’elle l’est désormais de l’usine [l’imprimerie]31 ».

Les années 60 et 70 sont marquées par une explosion de la créativité en typographie et dans la mise en page. L’intégration du procédé photographique a « libéré » la lettre grâce à de nouvelles marges de manœuvre typographique. Elle amorce un renouveau typographique considérable marqué par de nouveaux processus de production des caractères32. Il est aussi plus facile de jouer sur les caractères, les approches, les agrandissements et réductions de dernières heures, etc., donnant lieu à des compositions inédites. Les images et les textes peuvent être mélangés plus facilement et l’offset autorise l’utilisation de trames et de fonds colorés.

La facilité du mélange des médias visuels et typographiques est alors à l’origine de deux attitudes contradictoires : à la fois comme une libération des possibles et comme une dévalorisation de l’écrit au profit de l’image. Ce sont ces bouleversements qui ont motivé quelques années plus tôt l’idée de la création des Rencontres de Lure33. Dans les années 50, les fondateurs, conscients de l’imminence du changement technique qui attend les professionnels de l’écrit dans la transition du plomb à la photocomposition, se réunissent pour discuter de la « mort de Gutenberg34 ».

Les photocomposeuses libéreront l’imprimé de demain de nombreuses servitudes : la composition n’étant plus une construction rigoureuse de cubes (les signes en plomb), mais un libre assemblage d’images (les lettres photographiées), il en résultera nécessairement une révolution dans le domaine de l’esthétique graphique. En résultera-t-il aussi une révolution industrielle ?35

La

Publication Assistée par Ordinateur :

what you see is what you

get

Au milieu des années 80, la naissance de la publication assistée par ordinateur (PAO) est issue de la convergence de l’ordinateur personnel (ou micro-ordinateur) à interface graphique36, de l’imprimante laser, des logiciels de mise en page et du langage informatique de description et de manipulation de pages PostScript37.

En 1985, Albus Corporation lance Aldus PageMaker, un logiciel de mise en page et de composition qui permet d’intégrer pour la première fois texte et image dans une même page informatique. Les icônes utilisées dans le logiciel reprennent les outils du designer graphique sur sa table de montage : cutter, aérographe, pinceau, tampon, etc. Ces icônes perdurent encore aujourd’hui dans la majorité des logiciels de mise en page. Paul Brainerd38, co-fondateur d’Albus Corporation et ancien graphiste-maquettiste, explique que « la majorité de l’interface de PageMaker, et des dialogues, et de son fonctionnement proviennent de mon expérience en collage avec une lame de rasoir ou un scalpel39 ». En 1986, PageMaker est disponible à l’installation sur Macintosh, ordinateur qui a été lancé deux ans plus tôt.

La volonté de l’époque est de se rapprocher le plus possible de systèmes permettant de visualiser les pages à l’écran comme elles seront une fois imprimées et sorties de la ligne de production. C’est à ce moment que l’acronyme wysiwyg, « what you see is what you get » est inventé (signifiant littéralement en français « ce que vous voyez est ce que vous obtenez » mais parfois traduit comme « tel écran, tel écrit »). Le terme sert à aujourd’hui désigner toute interface utilisateur qui permet de composer visuellement le résultat voulu (les logiciels de mise en page, de traitement de textes ou d’images) en opposition aux interfaces en ligne de commande.

À ses débuts, la PAO surtout employée par de nouveaux opérateurs spécialisés et par le secteur administratif

L’apparition de la PAO génère d’abord un mouvement de méfiance dans les métiers traditionnels de la composition et de l’édition imprimée qui fustigent notamment la pauvreté du système automatique de justification, la déqualification de leur « savoir faire typographique » et la piètre qualité des premières imprimantes laser par lesquelles il faut passer alors pour imprimer le texte40.

Ainsi, la PAO est dans un premier temps adoptée dans les secteurs administratifs plus tournés vers une application bureautique décorrélée de l’industrie graphique et équipés d’imprimantes de bureautique (pas encore laser) dont la qualité est suffisante pour leurs travaux41. Les plus célèbres images du Xerox Star, le premier ordinateur à interface graphique et vantant le système what you see is what you get illustrent parfaitement cette idée. Elles montrent surtout des documents graphiques s’apparentant à ce que l’on trouve plus habituellement dans ces services de reprographies.

Pendant une dizaine d’année, entre 1984 et 1994 environ, la photocomposition et la PAO cohabitent dans les ateliers de composition. Les premiers utilisateurs des logiciels de mise en page sont d’anciens opérateurs de photocomposition – reconvertis en « opérateur PAO »42. Le reste de la chaîne graphique met du temps à évoluer et l’adoption de la PAO est finalement assez lente. Le temps d’adaptation est encore plus long du côté des graphistes et des maquettistes, par manque de formation, d’intérêt et de demande. Dans son article datant de 1997 – soit une quinzaine d’années environ après l’introduction de la PAO, Taylor Conrad indique que selon une étude australienne, seulement 2% de l’ensemble des mises en page effectuées à l’aide de la PAO sont faites par des graphistes.43

Un environnement de production hybride jusqu’au milieu des années 1990

Pourtant, pour les quelques graphistes aventureux·ses qui s’y intéressent, la PAO représentent une petite révolution. Les étapes de conception et de montage des maquettes fusionnent. Le système wysiwyg offre une meilleure interactivité avec le texte grâce à une réponse immédiate au moindre changement de paramètre. Malgré une résolution mauvaise, les modifications interactives de la mise en page permettent d’avoir un rendu plus rapide du graphisme. Ce retour immédiat de l’information transforme complétement la façon de penser la mise en page. Les premiers adeptes de ces systèmes ont des profils hybrides marqués par des intérêts pour la typographie, l’informatique, la rédaction, etc.

Pour ce qui me concerne, le Mac a été une libération. Je suis rédacteur et éditeur, typographe et illustrateur, maquettiste et photographe. J’ai toujours eu l’habitude de travailler sur des projets impliquant mes compétences en rédaction, édition et graphisme.44

La période de transition entre la photocomposition et une

complète intégration des systèmes de PAO est marquée par un

environnement de conception et de maquettage hybride, notamment

à cause du manque de

disponibilité de caractères sur les ordinateurs (non encore

numérisés) et l’absence de couleurs. Les méthodes et moyens de production

restent eux aussi analogues à l’ancienne chaîne graphique.

Bien que les textes puissent

être composés sur les micro-ordinateurs, il est toujours

nécessaire de fournir des films de texte et des films d’images aux

imprimeurs qui font l’assemblage. Les graphistes qui utilisent les

logiciels de PAO pour la mise en page et la composition des

ouvrages, impriment alors eux·elles-mêmes les différentes pages

avec les imprimantes

disponibles sur le marché puis doivent

faire flasher les pages au banc de reproduction afin de fournir

les films aux imprimeurs.

C’est au milieu des années 1990 que les choses changent radicalement, là aussi par une avancée technique. Le format PDF (Portable Document Format) présenté par Adobe Systems en 1992 permet de préserver l’ensemble de la mise en page (texte, images, objets graphiques) dans un seul fichier indépendamment de l’imprimante utilisée. Plus besoin de passer par une épreuve papier, le fichier informatique est directement envoyé à l’imprimeur.

Les graphistes deviennent de plus en plus autonomes pour leurs mises en page, ils·elles peuvent livrer des fichiers prêts à l’impression aux imprimeurs sans avoir recours aux services de photocomposition ou de flashage qui représentent des coûts considérables. Finalement, les possibilités d’exercer le travail de composition et de mise en page avec une machine aux dimensions réduites, s’apparentant à un matériel de bureau, a raison du système hyperspécialisé des industries graphiques. Les ateliers de composition, nécessitant d’importants capitaux, notamment pour l’achat des machines, s’effondrent au milieu des années 1990.

Une singularisation du travail des designers graphiques

L’adoption complète de la PAO dans le milieu des années 1990 délite alors la vision des métiers spécialisés et marque la disparition de certaines fonctions traditionnelles de la composition. À la fin des années 1990, la répartition des rôles dans la chaîne graphique est marquée par une grande confusion45. Les processus qui pendant des siècles étaient un effort industriel à grande échelle atterrissent dans les mains d’une seule personne et les tâches jadis dévolues aux compositeurs professionnels et aux photograveurs peuvent être prises en charge directement dans les logiciels de PAO. Cette époque est marquée par la naissance du designer graphique indépendant, non sans mal.

Alors que la composition typographique était jusque là partagée avec d’autres professions, elle relève soudainement entièrement des designers graphiques qui ne sont pas encore formés. Les ouvrages sont marqués par beaucoup d’erreurs de composition : justifications et césures hasardeuses, crénages douteux, fautes d’orthotypographie comme des mauvaises guillemets et les mauvais exposants, etc. Il faudra attendre un temps avant que les designers graphiques se familiarisent avec ces tâches jadis dévolues aux compositeur·rice·s et se forment aux règles et détails de composition.

Dans cette nouvelle division du travail, la structuration des textes par balisage s’est perdue avec la PAO. Il n’existe plus d’opérateur·rice dédié·e et l’activité de saisie revient entièrement à la charge du système éditorial qui dans le même temps, s’est trouvé transformé par le travail de bureautique et l’apparition de micro-ordinateurs de moins en moins coûteux. Ces évolutions marquent une séparation définitive entre l’édition, l’imprimerie et la composition et la mise en page. Ces dernières deviennent l’activité exclusive des designers graphiques avec leurs logiciels de PAO.

À la fin des années 1990,

plusieurs logiciels de mise en page cœxistent alors sur le marché,

parfois associés à des

machines spécifiques. En 1992,

QuarkXPress domine la quasi totalité du marché professionnel.

En 1999 sort Adobe In Design,

successeur de Page Maker, acquis par Adobe lors du rachat d’Aldus

en 1994. Il gagne très vite

des parts de marché en proposant un tarif d’achat deux fois moins

cher, des mises à jour plus

régulières et une interface considérée comme plus conviviale.

Il est aussi le premier

logiciel de PAO à offrir

l’utilisation de l’Unicode pour le traitement de texte (et donc

des possibilités de mise en page multilingues)46, des options de

typographie

avancée avec le support

de polices OpenType47 et des styles de

mise en page. Il est

aujourd’hui le logiciel utilisé par les designers graphiques de

manière hégémonique.

Outre ces guerres commerciales entre différents logiciels et l’ajout de fonctionnalités de plus en plus poussées, la publication Assistée par Ordinateur aujourd’hui n’a pas fondamentalement changée et repose sur les mêmes principes que ceux proposés à l’époque par Aldus Maker : interface wysiwyg et principe de table de montage hérité de l’époque de la photocomposition.

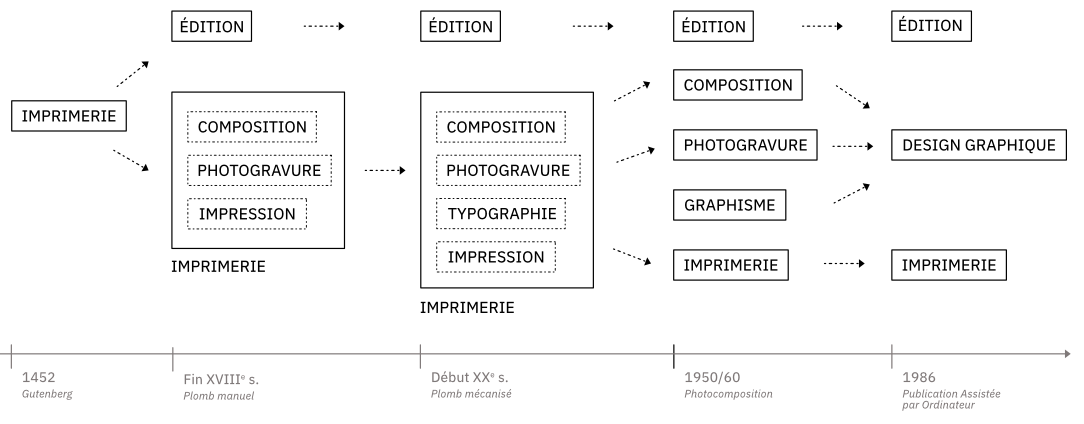

Évolution des relations entre les différents systèmes d’activité

Cette enquête sur le développement historique du design graphique et de la composition nous permet de révéler l’apparition, la division et le regroupement de différents systèmes d’activité au fil des siècles, résumé en figure XX. Les différentes apparitions de nouvelles technologies ont joué un grand rôle dans cette évolution socio-culturelle. Nous observons par ailleurs que l’évolution du design graphique et de l’imprimerie sont étroitement liée à celle de l’informatique.

Dès les années 1960, les machines de photocomposition intègrent des micro-ordinateurs, puis, dans les années 1970, des terminaux d’affichage sont inventés pour le travail de saisie des textes et de composition. À la fin des années 1970, les langages de balisages standardisés se développent pour décrire la structure des documents à composer et mettre en page avec les photocomposeuses et les machines de traitements de texte informatiques. Au milieu des années 1980, la naissance de la Publication assistée par ordinateur (PAO) est issue de la convergence de l’ordinateur personnel, de l’interface graphique, de l’imprimante laser, des logiciels de mise en page et du langage informatique de description et de manipulation de pages PostScript.48

Ainsi, progressivement, la chaîne de l’industrie graphique est profondément transformée et reconfigurée : des activités jusque-là exécutées par des corps de métiers distincts (compositeur-typographe, maquettiste, metteur en page) se retrouvent aux seules mains des graphistes qui organisent le domaine du design graphique tel que nous le connaissons aujourd’hui.

L’activité de composition et le Web

La composition de livres imprimés est une activité vieille de plusieurs siècles avec un ensemble de règles et de traditions transmises par des générations de typographes, compositeurs et imprimeurs. De nouveaux possibles apparaissent avec chaque évolution technique, que cela soit dans les ateliers de composition mécanique (Monotype et Linotype) ou avec la lumière (photocomposition), puis avec la micro-informatique et ses logiciels de PAO. Ensuite, l’apparition du Web et la demande accrue de publications multimédias font entrer dans la composition et la typographique des principes de flexibilité et fluidité des éléments pour les adapter à des pages sans dimensions fixes. Le développement web en tant qu’activité spécifique de conception de sites web explose à la fin des années 2000 et devient peu à peu une spécialité cloisonnée de la composition des objets imprimés. Pour autant, si nous regardons attentivement l’histoire de l’apparition du Web, ce cloisonnement peut être remis en question.

Courte histoire du Web

En effet, si aujourd’hui, le Web semble plus à voir avec des sites marchands, des applications closes et des réseaux sociaux, nous avons tendance à oublier qu’il a principalement été créé pour la publication de documents. Le Web est ainsi un système hypertexte public fonctionnant sur Internet, un réseau mondial de réseaux informatiques basés sur un ensemble standardisé de protocoles de transfert de données. En 1991, lorsque Tim Berners-Lee, informaticien britannique au CERN, publie le premier site web présentant les caractéristiques de son invention, il déclare : « The WorldWideWeb (W3) is a wide-area hypermedia information retrieval initiative aiming to give universal access to a large universe of documents49 ». Le scientifique tente ainsi de construire une toile de documents connectés, en particulier d’articles scientifiques, qu’il souhaite rendre accessibles aux scientifiques du monde entier gratuitement : « The [WWW] project is based on the philosophy that much academic information should be freely available to anyone50 ». Ajoutons qu’en 1993, le Web a été placé dans le domaine public, signalant la volonté d’ouverture et d’universalisme du projet. En ce sens, le Web porte dès son origine une dimension utopique dont ont été porteurs les pionnier·ère·s de l’informatique et d’Internet51.

Le World Wide Web Consortium (W3C)

Dès ses fondements, le web est pensé comme un système public, architecturé de manière décentralisé et ouvert à tous et à toutes. Pour répondre à ces objectifs, Tim Berners-Lee fonde le World Wide Web Consortium (abrégé W3C) le 1er octobre 1994. Le W3C est un organisme international de standardisation à but non lucratif dont l’objectif est d’assoir la gouvernance technique du Web et de développer des protocoles communs pour améliorer l’interopérabilité et l’évolution du Web.

En ce sens, les technologies du web sont des standards ouverts52 imaginés et maintenus par le W3C. Cela implique que les processus de standardisations sont accessibles de manière transparente, développés démocratiquement et qu’aucune entreprise ne peut en avoir le contrôle selon la philosophie de Tim Berners-Lee :

Le véritable art du consortium consisterait à trouver les accords minimaux, ou protocoles, dont tout le monde aurait besoin pour faire fonctionner le Web sur l’Internet. Ce processus ne mettait pas le consortium dans une position de contrôle ; il fournissait simplement un endroit où les gens pouvaient venir et parvenir à un consensus. (…) Qu’ils soient inspirés par les désirs du marché libre ou par des idéaux humanistes, nous avons tous senti que le contrôle n’était pas la bonne perspective. J’ai dit clairement que j’avais conçu le Web de manière à ce qu’il n’y ait pas de lieu centralisé (…). D’un point de vue philosophique, si le Web devait être une ressource universelle, il devait pouvoir se développer de manière illimitée. Techniquement, s’il y avait un point de contrôle centralisé, il deviendrait rapidement un goulot d’étranglement qui limiterait la croissance du Web, et le Web ne pourrait jamais s’étendre. Le fait qu’il soit « incontrôlable » était très important.53

Cette visée se traduit dans le leitmotiv actuel du W3C : « Web for all. Web on Everything54 ». Le consortium accueille toute sorte d’organisations intéressées par le futur du Web (entreprises tech, navigateurs web, laboratoires scientifiques, etc.)55.

HyperText Markup Language (HTML)

Dans cette idée, le Web requiert un langage simple, lisible et accessible sur toute plateforme. C’est ainsi que Tim Berners-Lee, secondé par Robert Cailliau, ingénieur et informaticien belge, propose l’HyperText Markup Language (HTML), un langage de balisage permettant de représenter la structure d’un document web à l’aide de balises ajoutées entre des phrases ou des mots pour indiquer le rôle du texte. Afin de l’afficher sur n’importe quel terminal quelle que soit sa capacité graphique d’affichage56, HTML est volontairement un langage très simple, et, surtout, sans aucune indication de mise en forme ou possibilité de contrôle de sa présentation (excluant toute modification des polices de caractères, des couleurs ou de la taille du texte).

Cascading HTML Style Sheets (CSS)

Très vite, les auteur·ices·s des sites web, ainsi que les

utilisateur·rice·s demanderont de plus en plus un moyen d’avoir la

main sur ce rendu. Des efforts

sont menés aussitôt pour proposer des concepts de feuilles de

styles pouvant s’appliquer à cet HTML et répondre à des besoins de présentation.

En 1994, Håkon Wium Lie,

informaticien norvégien, puis Bert Bos, informaticien

néerlandais,

formulent une

proposition de Cascading HTML Style Sheets, abrégé CSS.

La proposition repose sur

l’ambition de séparer complètement la structure HTML de son rendu

visuel grâce à des principes

de sélecteurs des éléments HTML spécifiés en CSS. Le principe de

cascade, c’est-à-dire la possibilité pour le style d’un document

d’être hérité à partir de

plusieurs « feuilles de style » séduit la communauté du web qui

cherchait un moyen d’arbitrer entre plusieurs sources de mise en

forme des éléments (issues des préférences stylistiques des

auteur·ice·s, des navigateurs et des utilisateur·rice·s). Il faudra cependant attendre le début

des années 2000 pour que CSS commence à être correctement implémenté dans

les navigateurs web. En 1999,

Internet Explorer 5 de Microsoft est le premier navigateur à supporter CSS de façon

convenable.

La création de CSS repose donc sur l’ambition de séparer le contenu et la structure sémantique d’un document de son rendu visuel. Ce principe de séparation du fond et de la forme est un principe informatique connu mais le Web est le seul environnement à avoir poussé cette idée aussi loin et à si grande échelle. L’affichage doit être proposé pour une multitude de médias afin que n’importe qui puisse y avoir accès. Dès sa première proposition, envoyée le 10 octobre 1994 sur la liste de diffusion www-talk@ cern.ch, Håkon Wium Lie indique que CSS est, lui aussi, pensé pour tous les médias, y incluant le papier : « Current browsers consider the computer screen to be the primary presentation target, but [CSS] has the potential of supporting many output media, e.g. paper, speech and braille57. »

Les requêtes médias, proposées dès 2002, consolideront cette

idée et la rendront techniquement possible. Elles consistent en des expressions CSS

permettant de définir si les styles s’appliquent à tel ou tel type de média. Par exemple, tous les styles contenus

dans la requête @ media print { … } ne s’appliqueront

qu’à la sortie imprimée de la page web. (Tous les navigateurs

possèdent aujourd’hui des fonctionnalités d’impression, souvent

disponible dans le menu Fichier > Imprimer).

CSS est encore aujourd’hui le seul langage entièrement dédié à la présentation visuelle de documents et au rendu graphique des pages web. C’est une invention unique, « radicale »58, dans le domaine informatique pour répondre à un enjeu jusqu’alors jamais imaginée dans l’histoire des médias : pouvoir, techniquement, exprimer à quel type de périphérique et quelle taille d’écran une règle stylistique particulière doit s’appliquer. Il est de ce fait, un langage profondément graphique, parfaitement adapté à la mise en page de tous types documents, en y incluant la composition imprimée.

Concevoir avec le langage CSS

Pendant longtemps, les contraintes techniques liées aux technologies du web ne permettaient pas de produire des mises en pages élaborées. Il n’était donc pas intéressant pour les designers graphiques de pratiquer ces technologies. Les choses se sont vite améliorées, les navigateurs web implémentant peu à peu des spécifications CSS permettant des rendus typographiques et graphiques de plus en plus poussés. Ces six dernières années ont notamment été marquées par des évolutions fulgurantes, depuis l’implémentation des grilles et des boîtes flexibles en CSS jusqu’au développement d’un nouveau format de polices de caractères permettant de rendre les fontes variables59 – le format OpenType variable fonts (OTVF) – et renouvelant par là même la création typographique.

Aujourd’hui, il est possible de concevoir des mises en page uniques (à l’écran comme pour l’imprimé) dans lesquelles la relation spatiale entre les éléments typographiques et les images est essentielle pour des raisons esthétiques et pour la compréhension du texte. Cependant, le langage CSS ayant été pensé pour répondre à la multiplicité des possibilités d’affichage des contenus sur un navigateur (et en dehors d’un navigateur web), l’organisation spatiale des contenus doit être imaginée différemment pour cadrer avec ces nouvelles propriétés de l’espace de la page web. De nouvelles notions jusqu’alors inconnue dans la mise en page ont fait leur apparition : comportement, adaptabilité, flux, personnalisation, variables, etc.

Contrairement à l’impression où les concepteur·rice·s contrôlaient tout le processus, sur le web, les lecteur·rice·s peuvent contrôler l’affichage de contenu, ne serais-ce qu’en choisissant la taille de la fenêtre sur lequel sera affiché le site web60. Les designers graphiques ne savent pas dans quelles conditions seront affichées les formes qu’ils·elles conçoivent. Ils·elles doivent donc produire et implémenter un ensemble de règles, de conditions, qui donneront lieu à des formes variables, mais maîtrisées, suivant des usages et des contextes de lecture multiples et changeant. En d’autres termes, les designers graphiques doivent maintenant composer avec des espaces flexibles, fluides.

La conception graphique de sites web transforme ainsi complètement certains aspects de la conception graphique rattachée jusqu’alœs aux ouvrages imprimés, comme l’exprime le designer Andrew LeClair :

Ce que j’aime avec l’utilisation du navigateur web, c’est que les choses sont fluides et donc que la conception est fluide. Lorsque vous concevez dans InDesign, vous placez chaque élément à un endroit particulier, et c’est statique. C’est amusant de commencer à établir des règles qui déterminent comment les choses doivent se dérouler dans un navigateur, et de voir comment ces règles peuvent produire des mises en page plus intéressantes. Cela ressemble plus à la construction d’un système qu’à celle d’une composition unique. (…) Lorsque vous concevez dans le navigateur, (…) vous pensez à cet arrangement et à de nombreux autres arrangements possibles qui émergent du système que vous avez mis en place. Si quelqu’un redimensionne son navigateur, à un moment donné, la proportion du titre devient trop importante par rapport au cadre (la fenêtre de visualisation dans laquelle la personne regarde le dessin). (…) Vous vous demandez à quel moment le système de relations que vous avez mis en place est déstabilisé et doit passer à un nouvel arrangement qui a du sens. Quels sont ces différents arrangements stables et comment faire en sorte que la transition se fasse sans heurts ?61

Notons aussi que le développement web s’est positionné comme un métier distinct et indépendant du design graphique (nous n’adhérons pas avec cette vision). Nous observons cette distinction dans les formations initiales en design graphique où les questions du web ont encore du mal à faire leur place. Les designers graphiques travaillant aujourd’hui avec les technologies du web affirment souvent s’être auto-formés. Pendant longtemps, du côté des designers graphiques indépendant·e·s, la création de site web a globalement souffert de l’image d’un projet de trop grande envergure. Cette image provient de phénomènes de professionnalisation portées par les entreprises spécialisées62 et l’utilisation intensive de templates et framework préconçus de plus en plus complexes à utiliser.

Un·e « designer graphique doit-il apprendre à coder ? » est une encore question récurrente dans le métier. Depuis le début de ce travail de recherche, cette question ne cesse d’évoluer et de plus en plus de designers graphique montrent un intérêt voire de réelles compétences pour le code avec la capacité de prendre entièrement en charge la conception et le développement d’un site web. Les relations entre design graphique et code se sont peu à peu consolidées en France63.

Nous y observons par ailleurs un mouvement spécifique du web design situé principalement dans un rapport critique aux sites commerciaux et consommateurs de ressources. Les questions de l’impact social, politique, économique et écologique du développement web y font en effet l’objet d’une attention particulière. Elles se traduisent sous la forme d’une recherche de radicalité, que Julien Bidoret, enseignant à l’École supérieure d’art et de design des Pyrénées, explore à travers la notion de « web design radical64 ». Il y défend que le web design radical se place dans une démarche tant d’ouverture, de durabilité, d’inclusivité que de sensibilité et de subversion, des notions qui nous semblent rejoindre le projet initial du World Wide Web et de son premier slogan : « Let’s Share What We Know » (en français, « Partageons ce que nous connaissons »).

La culture du logiciel libre

Le logiciel libre est né aux États-Unis sous le nom de « free software », et il est dès le départ un mouvement social avec des objectifs clairs : défendre le partage et la collaboration entre développeur·euse·s, permettre aux utilisateur·rice·s de contrôler leur informatique, et produire des technologies socialement utiles. C’est ainsi que l’a toujours qualifié son fondateur, Richard Stallman. Apportons quelques éléments de contexte liés à cette culture.

L’imprimante

de Xerox

et les logiciels

propriétaires

Il est fort intéressant de remarquer que l’histoire du logiciel libre commence de manière anecdotique avec une « histoire d’imprimante » comme nous l’enseigne la biographie de Richard Stallman 65. En 1980, alors qu’il est programmeur au laboratoire d’intelligence artificielle (AI Lab) du Massachussetts Institute of Technology (MIT), Stallman se retrouve confronté au blocage (bourrage papier) de la toute nouvelle imprimante Laser Xerox offerte par l’entreprise du même nom au laboratoire. Stallman souhaite alors modifier le logiciel de l’imprimante afin d’être averti à distance en cas de bourrage papier, chose qu’il a eu déjà l’occasion de faire pour d’autres imprimantes. Or, en cherchant le logiciel pilote de l’imprimante Xerox, il découvre un code inintelligible, pour lui-même ou pour d’autres programmeurs :

Jusqu’à présent, la plupart des sociétés avaient la courtoisie de publier le code source de leurs logiciels sous la forme de fichiers texte lisibles, qui tenaient lieu de documentation détaillant chaque commande. Or cette fois, Xerox n’avait fourni les fichiers du logiciel que sous une forme binaire (compilée). Si les programmeurs tentaient de l’ouvrir, ils ne pouvaient voir qu’une incompréhensible suite sans fin de 0 et de 1.66

Stallman va par la suite rencontrer un professeur au campus Carnegie Mellon dont on lui avait dit qu’il détenait le code source du logiciel. Ce dernier refuse de lui fournir une copie, selon un contrat passé avec Xerox. À l’aube des années 80, la politique de rétention du code des logiciels n’en est alors qu’à ses balbutiements. À mesure que l’informatique s’ouvre au grand public, notamment avec l’apparition de l’ordinateur personnel, l’industrie du logiciel devient un domaine lucratif où le logiciel est un actif avec une valeur marchande à préserver en la protégeant par un contrat de licence et en contrôlant son utilisation. Jusqu’alors la question du partage du code ne se posait pas.

Le monde des informaticiens passa ainsi en quelques années d’une culture professionnelle dominée par des normes universitaires (publicité du savoir, collaboration et jugements par les pairs) à une pratique de la programmation organisée autour d’impératifs commerciaux. Cette transformation fut grandement facilitée par la massification du marché de l’informatique. Tant que la majorité des utilisateurs de logiciels étaient aussi des programmeurs compétents, il existait une forte demande pour que les logiciels soient fournis sous une forme qui en permette la modification. Quand les micro-ordinateurs touchèrent le grand public, celui-ci n’accorda que peu d’importance à la possibilité d’accéder au code source, celle-ci n’étant d’aucune utilité en l’absence de compétence technique adéquate. De façon quelque peu ironique, une innovation qui avait été pensée pour « démocratiser l’accès à l’information » eut ainsi pour effet de restreindre la circulation du code entre informaticiens.67

Les 4 libertés du logiciel libre

Cette histoire d’imprimante marque profondément Stallman, qui va jusqu’à employer le terme de « trahison » envers l’idéal de partage entre pairs prônés par les hackers, terme désignant alors les passionnés d’informatique officiant essentiellement dans les cercles du monde universitaire et « où tout programme était considéré comme une ressource collective »68.

En 1983, Richard Stallman initie le projet GNU, un ensemble de logiciels qui constitue aujourd’hui l’un des piliers des systèmes libres GNU/Linux. Le 4 octobre 1985, il fonde la Free Software Foundation (FSF) dont la mission est la promotion du logiciel libre et la défense des utilisateur·rice·s. Une première ébauche de définition du logiciel libre est proposée l’année suivante, publiée dans le premier bulletin de GNU :

First, the freedom to copy a program and redistribute it to your neighbors, so that they can use it as well as you. Second, the freedom to change a program, so that you can control it instead of it controlling you ; for this, the source code must be made available to you69.

En 1989, afin d’assoir juridiquement le projet, Stallman rédige la GNU General Public License (GNU GPL), un contrat destiné à accompagner ses logiciels pour protéger le projet GNU en réaction à l’usage qu’il juge abusif des lois sur le copyright. Ce contrat s’articule autour de quatre principes, quatre libertés accordées aux utilisateur·rice·s :

- la liberté de faire fonctionner le programme comme vous voulez, pour n’importe quel usage (liberté 0) ;

- la liberté d’étudier le fonctionnement du programme, et de le modifier pour qu’il effectue vos tâches informatiques comme vous le souhaitez (liberté 1) ; l’accès au code source est une condition nécessaire ;

- la liberté de redistribuer des copies, donc d’aider les autres (liberté 2) ;

- la liberté de distribuer aux autres des copies de vos versions modifiées (liberté 3) ; en faisant cela, vous donnez à toute la communauté une possibilité de profiter de vos changements ; l’accès au code source est une condition nécessaire.70

Ainsi, le logiciel libre repose sur un socle à la fois technique et légal. Du point de vue technique, les logiciels libres se caractérisent par l’accès au code source, condition sine qua non pour pouvoir les modifier, d’un point de vue légal, ils doivent être accompagnés d’une licence.

Stellman introduit par la même occasion la notion de « copyleft », inspiré par son ami Don Hopkins, et qui symbolise son combat culturel le plus abouti, celui de remettre en cause la propriété intellectuelle 71. Avec cette idée, Stellaman se joue du « copyright » imposé à tous les logiciels informatiques en 1980 aux États-Unis à la faveur du Software Copyright Act. Ainsi, le copyleft se veut un détournement du copyright par l’ajout d’une licence spécifique. Le concept de copyleft symbolise en ce sens l’esprit créatif et moqueur de la culture hacker MIT de laquelle est issue Stallman et ses collègues.

L’ethos de la culture du logiciel libre

Les logiciels libres sont intrinsèquement liés à la liberté des utilisateur·rice·s. Stallman résume ainsi leur différence avec les logiciels propriétaires : « Dans le cas du Logiciel Libre, l’utilisateur contrôle le programme. L’autre cas est celui du Logiciel Propriétaire, qui signifie que le programme contrôle l’utilisateur et que l’éditeur contrôle le programme.72 » Mais la culture du logiciel libre véhicule des valeurs qui vont bien au-delà de cette idée. Ainsi, elle s’incarne dans tout un panel d’expressions non technologiques qui se sont progressivement étendues hors du domaine informatique pour devenir un mouvement social d’une grande portée et une culture à part entière ; « le Libre désigne aujourd’hui un vaste domaine dont les logiciels libres sont l’infrastructure, les licences libres le règlement, et l’activisme libriste le gardien73 ».

Depuis le début des année 2000, la culture du Libre s’incarne en effet de façon renouvelée dans des champs plus ou moins loin du logiciel comme le montre des projets comme Wikipédia, inspiré par les formes de collaboration du développement logiciel ou encore le développement de l’open hardware, du Do It Yourself et de l’Open design74. En tant que mouvement social, le logiciel libre s’est aussi peu à peu enraciné dans un activisme politique croissant touchant à des questions de transmission des savoirs, de diffusion des œuvres, de défense de la démocratie et de la vie privée ou de lutte contre des modèles de surveillance. Les libristes sont ainsi de fervents défenseurs de la « neutralité du Net » et vont parfois jusqu’à participer à des actions défendant les droits de l’homme et les libertés politiques.

En ce sens, Sébastien Broca, dans son livre Utopie du logiciel libre. Du bricolage informatique à la réinvention sociale propose de définir l’ethos75 de la culture du logiciel libre – entendu comme « un ensemble de valeurs qui constituent un cadre pour l’action et s’actualisent dans des pratiques 76 » – à travers trois points :

La revendication d’autonomie dans le travail

L’histoire du logiciel libre est tout d’abord celle de la promotion d’une certaine autonomie dans le travail et met l’accent sur la passion et l’intérêt personnel plutôt que sur le devoir moral et l’intérêt financier. Ses participant·e·s cherchent à réduire les formes de subordination hiérarchique et à intégrer le travail dans une dynamique de réalisation de soi.

Le free software émerge au moment où la naissance de l’industrie du logiciel met à mal non seulement le partage et la collaboration entre informaticiens, mais aussi la capacité de ceux-ci à déterminer par eux-mêmes le contenu et les formes d’exercice de leur activité. (…) [Dans les pratiques des hackers,] l’important serait la satisfaction personnelle éprouvée dans la réalisation d’une tâche vécue comme intrinsèquement intéressante et gratifiante. Le travail s’intégrerait ainsi à une dynamique générale de réalisation de soi, en vertu d’une réduction des formes de subordination hiérarchique, et grâce à l’impossibilité de « clôturer » les fruits de l’activité productive : les logiciels.77

La promotion d’un rapport actif et créatif aux objets techniques

Le mouvement du logiciel libre s’oppose « au ‹ culte de la technologie › qui maintient le grand public dans l’ignorance du fonctionnement de la technologie78 » et à une dépendance passive envers elle. Ses partisan·ne·s cherchent à permettre aux citoyen·ne·s de comprendre, de maîtriser et d’adapter les technologies à leurs besoins spécifiques. Ils·elles défendent en cela un rapport créatif aux technologies issu de la culture du hacking.

[La culture du hacking]pousse à évaluer les bénéfices de chaque technologie en fonction des possibilités d’apprentissage, de détournement ludique et d’action créative qui lui sont liées. Les libristes critiquent ainsi les logiciels propriétaires, les DRM ou Facebook, en tant qu’ils diminuent les possibilités d’agir sur la technique et avec la technique. Ils les rejettent parce qu’ils incorporent des limitations d’usage et entrainent de ce fait une forme de « prolétarisation » : un appauvrissement des savoirs et des savoir-faire des individus. Une proposition utopique émerge de cette critique. Il faudrait recréer un nouvel ensemble technologique « à hauteur d’homme » qui éviterait la dépendance envers de grandes entreprises opaques, mettrait le bidouillage à la portée de tous et inclinerait chacun à faire par lui-même plutôt qu’à consommer.79

La défense militante de la circulation de l’information

Il est enfin impossible de parler du Libre sans évoquer la croyance dans les bénéfices sociaux engendrés par la libre circulation de l’information Cette conviction remonte selon Broca à la première cybernétique et aux écrits de Norbert Wiener dans l’immédiat après-guerre. Le mathématicien du MIT (Massachussets Institute of Technology) estimait en effet que l’information était la clé de compréhension du monde et sa circulation la condition du progrès humain. Il s’opposait pour cette raison à sa marchandisation, susceptible de ralentir sa transmission et de diminuer son utilité sociale. Limitée à l’origine au domaine informatique, cette critique s’est peu à peu généralisée. La culture du « Libre » milite ainsi aujourd’hui aussi pour une libération des œuvres de l’esprit en encourageant leur libre circulation et leur libre modification. La création des licences Creatives Communs en est un exemple typique80.

La défense de la circulation de l’information est enfin au cœur d’une mise en question de la régulation néolibérale des échanges informationnels. (…) Le Libre a ainsi activement contribué à politiser des questions qui étaient auparavant presque absentes du débat public. Depuis son point de vue singulier, il a nourri une mise en question de l’extension des logiques de marché à la majorité des activités sociales.81

Ces différentes valeurs sont incarnées, construites et affinées dans un va-et-vient constant avec des pratiques techniques, sociales et politiques (écrire du code, rédiger des licences, organiser le travail collaboratif, militer contre les textes législatifs, etc.). Ainsi, la culturel du logiciel libre fonctionne comme une critique sociale en acte :

Bien que le logiciel libre et ouvert soit avant tout un mouvement technique fondé sur les principes de la liberté d’expression, son rôle historique dans la transformation d’autres domaines de la vie n’est pas principalement ancré dans le pouvoir du langage ou dans l’articulation discursive d’une vision politique large. Au contraire, il fonctionne effectivement comme une politique de critique en fournissant un contre-exemple vivant ou, pour reprendre les mots du plus célèbre conseiller juridique du logiciel libre, Eben Moglen : « La révolution pratique est basée sur deux choses : la preuve du concept et l’exécution du code ».82

La

collaboration,

au cœur des

controverses du libre

Mouvement à l’origine marginal, il existe aujourd’hui une industrie et une économie du Libre. Une part importante des logiciels les plus performants aujourd’hui utilisés dans le monde notamment par les entreprises sont des logiciels libres83. Pour parvenir à cet exploit, les aspects les plus subversifs du mouvement ont été délaissés au profit d’un discours plus consensuel et plus pragmatique autour de la collaboration ouverte. Ainsi, depuis les années 1990, deux conceptions du logiciel libre s’affrontent entre free software et open source.

La création de l’Open Source Initiative marque l’avènement de l’open source. Portée notamment par Linus Torvalds, fondateur de Linux, l’open source est une méthode de développement reposant sur l’ouverture du code, sans que les valeurs de la culture du logiciel libre y soient nécessairement associées. Ce mouvement s’appuie sur un discours visant à défendre une meilleure adéquation des principes d’ouverture avec les enjeux économiques et commerciaux du capitalisme. L’idée étant de dire que l’open source peut être une alternative viable, en termes commerciaux et techniques, au logiciel propriétaire. L’open source se focalise ainsi plutôt sur des considérations techniques de développement logiciel et l’organisation du travail communautaire. (Dans la pratique toutefois, la très grande majorité des logiciels open source sont également libres).

Ainsi, pour le mouvement de l’open source, l’accès au code source est une question pratique et non éthique. C’est un mouvement lié à une méthodologie de développement. Alors que pour le mouvement du logiciel libre, c’est une question sociale. Quoi qu’il en soit, free software (mouvement politique) et open source (méthode de développement) sont au cœur des mutations contemporaines des activités de travail en faisant émerger « de nouvelles formes de coordination, irréductibles aux organisations formelles ou aux réseaux structurés, caractérisées par une faible formalisation, une grande plasticité et une efficacité productive notable84 ».

La participation y est vue comme un facteur essentiel du succès des logiciels libres et se base sur la coopération d’une multitude de développeur·euse·s, se caractérisant par une adaptabilité et une flexibilité associée au modèle du « bazar85 ». Cette expression d’Eric S. Raymond vise à souligner l’opposition aux organisations managériales traditionnelles de « type cathédrale » marquées par une hiérarchie et une structuration forte. Le « bazar » est, lui, fondé sur l’existence d’un réseau égalitaire de développeur·euse·s affranchi·e·s de toute organisation hiérarchisée et de tout contrôle centralisé. La méritocratie et le contrôle du code par les pairs y jouent un rôle essentiel86.

Comme tout système d’activité, celui du logiciel libre et open source est aussi traversé par des contradictions. Par exemple, les personnes impliquées dans la conception des logiciels libres ont souvent pour éthique de travailler en dehors des relations de marché. Cela pose alors des questions sur le profil des personnes capables de participer à de tels projets. Par ailleurs, la demande toujours plus grande de logiciel libre et open source pour des raisons « étique » et « écologique » n’est pas toujours suivie par une plus grande communauté de contributeur·rice·s, ce qui entraîne des questions sur la charge de travail reposant sur un petit groupe de personnse.

Conclusion sur le logiciel libre

La culture du logiciel libre nous permet donc de considérer en quoi des facteurs sociaux, économiques et culturels façonnent les technologies. Nous retiendrons particulièrement de la culture du logiciel libre sa volonté d’articuler technologies et changement social. Il nous paraît particulièrement intéressant de noter à ce stade que la culture du logiciel libre rejoint les préoccupations de l’approche instrumentale et des théories historico-culturelle de l’activité que nous avons choisi de mobiliser comme cadre théorique de cette recherche.

D’un côté, elle prône un rapport actif aux technologies visant à « inverser ce qui constitue aujourd’hui le rapport dominant aux objets techniques, afin de devenir capable de comprendre, maîtriser et in fine adapter ceux-ci à nos besoins particuliers87 », touchant là aux intentions initiales de Rabardel. De l’autre, elle touche à la question de la transformation du politique par le faire, invitant chacun à être acteur·rice du changement social, comme les théories historico-culturelle de l’activité le soutiennent :

La faculté de prendre part à la vie politique n’est plus séparée du travail humain en tant que fait matériel et concret, mais mêlée à lui de manière inédite. Car un logiciel n’est pas un problème abstrait ou une quête intellectuelle ; il est au cœur même du travail manuel et technique moderne, que ce soit en tant que fin ou en tant que moyen.88

Enfin notons que la culture du logiciel libre milite pour la transformation des organisations du travail en promouvant l’importance de la réalisation de soi et d’autonomie, sans toutefois négliger l’importance de la collaboration.